Die verpflichtende Nutzung generativer KI-Anwendungen in der Hochschullehre, z.B. im Rahmen einer Studienleistung, ist nur möglich, wenn es hierfür datenschutzkonforme Lösungen gibt. Viele externe, frei verfügbare KI-Anwendungen erfordern eine Anmeldung unter Angabe personenbezogener Daten (E-Mail, Telefonnummer, teilweise Kreditkartennummer). Für den Einsatz in der Lehre kann dies von den Studierenden mangels Rechtsgrundlage nicht verlangt werden.

Die MLU stellt daher ihren Lehrenden und Studierenden einen eigenen, datenschutzkonformen Zugang "MLU-KI" (https://ki.uni-halle.de/ aus dem Uninetz/VPN) auf Basis der bundesweit verfügbaren Schnittstelle HAWKI bereit. Der Zugang ist über das normale Nutzerkürzel zu erreichen, erfordert aber zwingend das Uni-LAN, Uni-WLan oder VPN. Bei der Konzeption wurde besonderen Wert auf den Datenschutz gelegt, so sind z.B. die Chatverläufe verschlüsselt lokal gespeichert und können über einen Access-Key individuell auch auf andere, eigene Geräte übertragen werden. Der Access-Key wird beim ersten Login angelegt und wird für Übertragungen, aber auch für Wiederherstellungen benötigt (Anleitung).

! Allgemeiner Hinweis: Die Sprachmodelle sind allesamt kein Ersatz für eine Suchmaschine und auch nicht für wissenschaftliche Literaturrecherche geeignet. Sie verfügen weder über eine Onlinesuche, noch über tagesaktuelle Trainingssätze und haben keine Anbindung an Literaturdatenbanken !Kurzeinstieg:

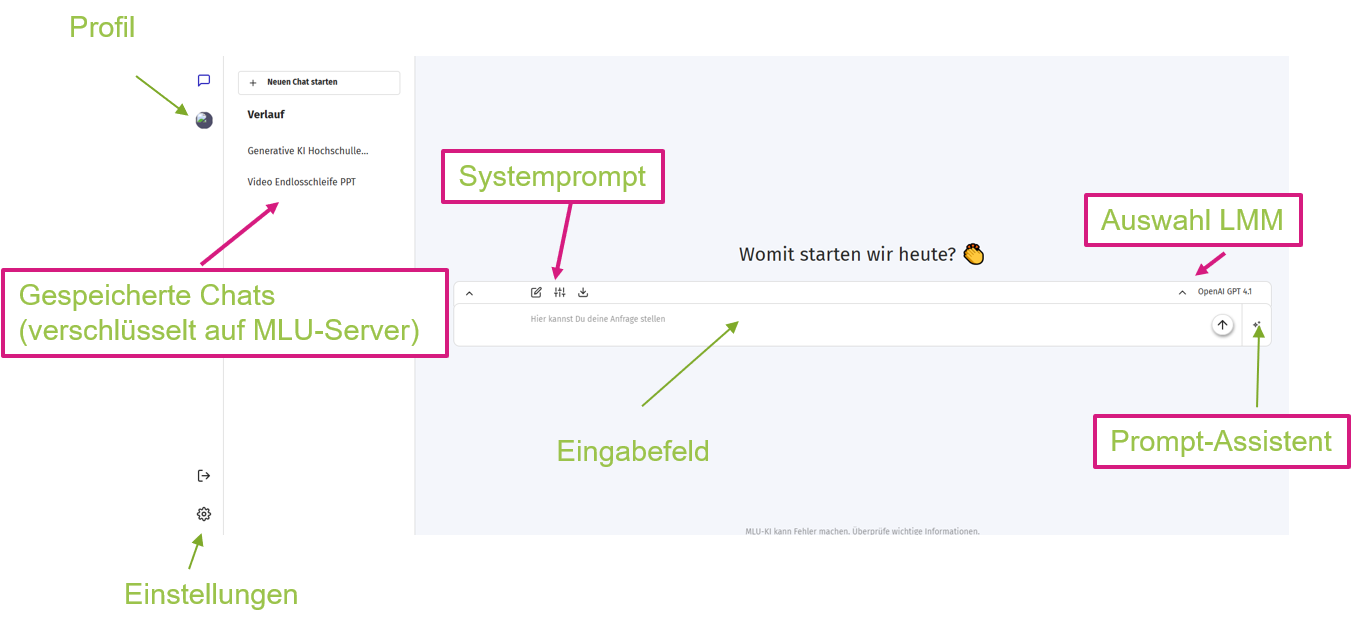

Rund um das Eingabefeld können Sie das Sprachmodell wählen, bei Bedarf ihren Prompt mithilfe des Assistenten verbessern (also mehr Kontext hinzufügen) und den Systemprompt anpassen. Der Systemprompt liefert der KI zusätzlichen Kontext, so könnte man beispielsweise dort die Rolle eines Lernassistenten für ein Fachgebiet festlegen, der mit Wissensfragen auf die Eingaben reagiert und diese bewertet. Die Navigation links listet Ihre bisherigen Chatverläufe, führt zu den Einstellungen und zum eigenen Profil. Das eigene Profil wird dann wichtig, wenn das Feature Gruppenchat freigeschaltet wird (derzeit noch deaktiviert).

Für die Erstbenutzung von MLU-KI empfehlen wir das Video sowie weiter unten die detaillierte Anleitung.

Beschreibung der an der MLU eingesetzten Sprachmodelle (in Klammern Herkunft und Stand Trainingssätze):

Das Angebot an LLM's umfasst derzeit (Stand 20.05.2025) insgesamt sowohl drei kostenfreie Open-Source Sprachmodelle sowie einen kostenpflichtigen Zugänge zu ChatGPT-4. Die Kosten für ChatGPT werden derzeit von der MLU übernommen.

Mistral AI (Frankreich, Juli 2024)

Mistral Large Instruct ist ein europäisches Sprachmodell. Es ist auf Instruct-Aufgaben für Anweisungen in natürlicher Sprache optimiert und erreicht eine hohe Geschwindigkeit bei entsprechender Installation. Das Modell zeigt starke Leistungen in Programmieraufgaben und übertrifft teilweise Llama 3.1 405B. Es eignet sich besonders für Anwendungen mit hohem Durchsatz wie Echtzeit-Chatbots und Programmierassistenten. Lange Kontexte werden unterstützt.

Llama 3.1 (Meta Platforms, USA, Dezember 2023)

Llama 3.1 70B ist für eine breite Nutzung angelegt und eignet sich für Textgenerierung, Codierung und logischem Denken. Es übertrifft GPT-4o in bestimmten Benchmarks. Es ist vielseitig einsetzbar in Forschung, Bildung und Unternehmen. Die Verarbeitung erfolgt mit guter Geschwindigkeit. Das Modell unterstützt Kontexte bis zu 128.000 Tokens Kontext. Hier wird ein Update auf 4.1 erwartet.

Qwen 2.5 Coder 32B (Alibaba Cloud, China, September 2024)

Qwen 2.5 Coder 32B ist auf Programmieraufgaben spezialisiert und bietet sehr gute Leistungen in Codegenerierung und Codereparatur. Es übertrifft dabei größere Modelle in Benchmarks. Das Modell eignet sich besonders für Entwickler und Unternehmen mit Schwerpunkt Softwareentwicklung. Es arbeitet mit guter Geschwindigkeit und unterstützt mehrere Programmiersprachen sowie mathematische Aufgaben

ChatGPT 4.1. (OpenAI, USA, Juni 2024)

Das aktuelle ChatGPT-Modell basiert auf GPT-4-turbo und ist auf Instruct-Aufgaben optimiert. Es liefert hohe Genauigkeit, gute Sprachqualität und hohe Leistungen im logischen Denken, Textverarbeitung und Programmieraufgaben. Das Modell ist vielseitig einsetzbar in der Bildung. Es unterstützt lange Kontexte mit bis zu 1 Mio Tokens und bietet je nach gebuchtem Umfang auch Zusatzfunktionen. Die Geschwindigkeit ist hoch und anwendungsfreundlich.

ChatGPT 4.1. mini (OpenAI, USA, Juni 2024)Das Sprachmodell liefert kürzere Ausgaben als das größere Modell, berücksichtigt aber genau so viel Kontext (1 Mio Token). Es liefert aber ebenso hohe Genauigkeit, gute Sprachqualität und hohe Leistungen im logischen Denken, Textverarbeitung und Programmieraufgaben. Das Modell ist vielseitig einsetzbar in der Bildung. Die Antwortgeschwindigkeit ist am schnellsten von allen Modellen.Links